Теорема Байеса

Теорема Байеса (или формула Байеса) — одна из основных теорем элементарной теории вероятностей, которая позволяет определить вероятность события при условии, что произошло другое статистически взаимозависимое с ним событие. Другими словами, по формуле Байеса можно уточнить вероятность какого-либо события, взяв в расчёт как ранее известную информацию, так и данные новых наблюдений. Формула Байеса может быть выведена из основных аксиом теории вероятностей, в частности из условной вероятности. Особенность теоремы Байеса заключается в том, что для её практического применения требуется большое количество расчётов, вычислений, поэтому байесовские оценки стали активно использовать только после революции в компьютерных и сетевых технологиях. На сегодняшний день активно применяется в машинном обучении и технологиях искусственного интеллекта.

При возникновении теоремы Байеса вероятности, используемые в теореме, подвергались целому ряду вероятностных интерпретаций. В одной из таких интерпретаций говорилось, что вывод формулы напрямую связан с применением особого подхода к статистическому анализу. Если использовать байесовскую интерпретацию вероятности, то теорема показывает, как личный уровень доверия может кардинально измениться вследствие количества наступивших событий. В этом заключаются выводы Байеса, которые стали основополагающими для байесовской статистики. Однако теорема не только используется в байесовском анализе, но и активно применяется для большого ряда других расчётов.

Психологические эксперименты[1] показали, что люди часто неверно оценивают реальную (математически верную) вероятность события, основываясь на некоем личном полученном опыте (апостериорная вероятность), поскольку игнорируют саму вероятность предположения (априорная вероятность). Поэтому правильный результат по формуле Байеса может сильно отличаться от интуитивно ожидаемого.

Теорема Байеса названа в честь её автора Томаса Байеса (1702—1761) — английского математика и священника, который первым предложил использование теоремы для корректировки убеждений, основываясь на обновлённых данных. Его работа «An Essay towards solving a Problem in the Doctrine of Chances» впервые опубликована в 1763 году[2], через 2 года после смерти автора. До того, как посмертная работа Байеса была принята и прочитана в Королевском обществе, она была значительно отредактирована и обновлена Ричардом Прайсом. Однако эти идеи не предавались публичной огласке до тех пор, пока не были вновь открыты и развиты Пьером-Симоном Лапласом, впервые опубликовавшим современную формулировку теоремы в своей книге 1812 года «Аналитическая теория вероятностей».

Сэр Гарольд Джеффрис писал, что теорема Байеса «для теории вероятности то же, что теорема Пифагора для геометрии»[3].

Формулировка[править | править код]

Формула Байеса:

- ,

где

- — априорная вероятность гипотезы A (смысл такой терминологии см. ниже);

- — вероятность гипотезы A при наступлении события B (апостериорная вероятность);

- — вероятность наступления события B при истинности гипотезы A;

- — полная вероятность наступления события B.

Доказательство[править | править код]

Формула Байеса вытекает из определения условной вероятности. Вероятность совместного события двояко выражается через условные вероятности

Следовательно

Вычисление P(B)[править | править код]

В задачах и статистических приложениях обычно вычисляется по формуле полной вероятности события, зависящего от нескольких несовместных гипотез, имеющих суммарную вероятность 1.

- ,

где вероятности под знаком суммы известны или допускают экспериментальную оценку.

В этом случае формула Байеса записывается так:

«Физический смысл» и терминология[править | править код]

Формула Байеса позволяет «переставить причину и следствие»: по известному факту события вычислить вероятность того, что оно было вызвано данной причиной. При этом необходимо понимать, для применения теоремы причинно-следственная связь между и не является обязательной.

События, отражающие действие «причин», в данном случае называют гипотезами, так как они — предполагаемые события, повлёкшие данное. Безусловную вероятность справедливости гипотезы называют априорной (насколько вероятна причина вообще), а условную — с учётом факта произошедшего события — апостериорной (насколько вероятна причина оказалась с учётом данных о событии).

Примеры[править | править код]

Пример 1[править | править код]

Пусть событие — машина не заводится, а гипотеза — в баке нет топлива. Очевидно, что вероятность того, что машина не заведётся, если в баке нет топлива, равняется единице. Как следствие, апостериорная вероятность, что в баке нет топлива, если машина не заводится, то есть , равна , то есть отношению априорной вероятности, что в баке нет топлива, к вероятности, что машина не заводится. Например, если априорная вероятность, что в баке нет топлива, равна 0,01, а вероятность, что машина не заводится, равна 0,02, и случайно выбранная машина не завелась, то вероятность, что в её баке нет топлива, равна 0,5.

Пример 2[править | править код]

Пусть вероятность брака у первого рабочего , у второго рабочего — , а у третьего — . Первый изготовил деталей, второй — деталей, а третий — деталей. Начальник цеха берёт случайную деталь, и она оказывается бракованной. Спрашивается, с какой вероятностью эту деталь изготовил третий рабочий.

Событие — брак детали, событие — деталь произвёл рабочий . Тогда , где , а .

По формуле полной вероятности

По формуле Байеса получим:

Пример 3[править | править код]

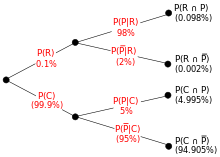

Энтомолог предполагает, что жук может относиться к редкому подвиду жуков, так как у него на корпусе есть узор. В редком подвиде 98 % жуков имеют узор, или P(узор | редкий) = 0,98. Среди обычных жуков только 5 % имеют узор: P(узор | обычный) = 0,05. Редкого вида жуков насчитывается лишь 0,1 % среди всей популяции: P(редкий) = 0,001. Какова вероятность того, что жук, имеющий узор, относится к редкому подвиду, то есть, чему равно P(редкий | узор)?

Из расширенной теоремы Байеса получаем (любой жук может относиться либо к редким, либо к обычным):

Пример 4 — парадокс теоремы Байеса[править | править код]

Пусть существует заболевание с частотой распространения среди населения 0,001 и метод диагностического обследования, который с вероятностью 0,9 выявляет больного, но при этом имеет вероятность 0,01 ложноположительного результата — ошибочного выявления заболевания у здорового человека (подробнее…). Найти вероятность того, что человек здоров, если он был признан больным при обследовании.

Обозначим событие что обследование показало, человек болен как «болен» с кавычками, болен — событие, что человек действительно больной, здоров — событие, что человек действительно здоров. Тогда заданные условия переписываются следующим образом:

, при этом , значит:

Вероятность того, что человек здоров, если он был признан больным равна условной вероятности:

Чтобы её найти, вычислим сначала полную вероятность признания больным:

Вероятность, что человек здоров при результате «болен»:

Таким образом, 91,7 % людей, у которых обследование показало результат «болен», на самом деле здоровые люди. Причина этого в том, что по условию задачи вероятность ложноположительного результата хоть и мала, но на порядок больше доли больных в обследуемой группе людей.

Если ошибочные результаты обследования можно считать случайными, то повторное обследование того же человека будет давать независимый от первого результат. В этом случае для уменьшения доли ложноположительных результатов имеет смысл провести повторное обследование людей, получивших результат «болен». Вероятность того, что человек здоров после получения повторного результата «болен», также можно вычислить по формуле Байеса:

Варианты интерпретации вероятностей в теореме Байеса[править | править код]

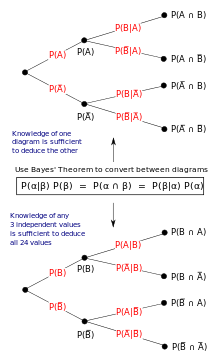

Математически теорема Байеса показывает взаимоотношения между вероятностью события A и вероятностью события B, P(A) и P(B), условной вероятности наступления события А при существующем B и наступлении события B при существующем A, P(A | B) и P(B | A).

В общей форме формула Байеса выглядит следующим образом:

Значение выражения зависит от того, как интерпретируются вероятности в данной формуле.

Интерпретация Байеса[править | править код]

В интерпретации Байеса вероятность измеряет уровень доверия. Теорема Байеса связывает воедино доверие предположению до и после принятия во внимание очевидных доказательств. Например, кто-то предположил, что при подкидывании монетки она будет приземляться в 2 раза чаще решкой вверх, а орлом вниз. Первоначально степень доверия, что такое событие случится, монета упадёт именно так — 50 %. Уровень доверия может увеличиться до 70 %, если предположение будет подтверждено доказательством.[прояснить]

Для предположения (гипотезы) A и доказательства B

- P(A) — априорная вероятность гипотезы A, первоначальный уровень доверия предположению A;

- P(A | B) — апостериорная вероятность гипотезы A при наступлении события B;

- отношение P(B | A)/P(B) показывает, как событие B помогает изменить уровень доверия предположению A.

Частотная интерпретация[править | править код]

В частотной интерпретации теорема Байеса исчисляет доли определённых результатов события. Предположим, что некий эксперимент проводился много раз и в некоторых случаях приводил к результатам А и/или B. Тогда:

- P(A) — доля случаев, когда эксперимент привёл к результату A.

- P(B) — доля случаев, когда эксперимент привёл к результату B.

- P(B | A) — доля случаев с результатом B среди случаев с результатом А.

- P(A | B) — доля случаев с результатом A среди случаев с результатом B.

Роль теоремы Байеса лучше всего можно понять из древовидных диаграмм, представленных справа. Диаграммы демонстрируют различный порядок распределения событий по наличию или отсутствию результатов A и B. Теорема Байеса выступает как связующее звено этих распределений.

Формы[править | править код]

События[править | править код]

Простая форма[править | править код]

Для событий A и B, при условии, что P(B) ≠ 0,

Во многих дополнениях к теореме Байеса указывается, что событие B известно и нужно понять, как знание о событии B влияет на уверенность в том, что произойдёт событие A. В таком случае знаменатель последнего выражения — вероятность наступления события B — известен; мы хотим изменить A. Теорема Байеса показывает, что апостериорные вероятности пропорциональны числителю:

- (пропорциональность A для данного B).

Если говорить кратко: апостериорная вероятность пропорциональна априорной вероятности (смотри Lee, 2012, Глава 1).

Если события A1, A2, …, взаимоисключающие и исчерпывающие, то есть возможно только одно из событий, одновременно два события не могут случиться вместе, мы можем определить коэффициент пропорциональности, ориентируясь на то, что их вероятности в сумме должны составлять единицу. Например, для данного события A — само событие A и его противоположность ¬A взаимоисключающие и исчерпывающие. Обозначая коэффициент пропорциональности как C мы имеем:

- и .

Объединив эти две формулы, мы получим, что:

Расширенная форма[править | править код]

Часто пространство событий (таких как {Aj}) определённо в терминах P(Aj) и P(B | Aj). Именно в этом случае полезно определить P(B), применив формулу полной вероятности:

В частности

- .

Непрерывные случайные величины[править | править код]

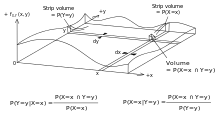

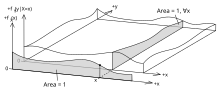

Рассмотрим пространство элементарных событий Ω, образованного двумя величинами X и Y. В принципе, теорема Байеса применяется к событиям A = {X = x} и B = {Y = y}. Однако выражения становятся равны 0 в точках, в которых переменная имеет конечную плотность вероятности. Для того, чтобы с пользой продолжать использовать теорему Байеса, можно её сформулировать в терминах подходящих плотностей (смотрите Вывод формул).

Простая форма[править | править код]

Если X непрерывна и Y дискретна, то

Если X дискретна и Y непрерывна,

Если как X, так и Y непрерывны,

Расширенная форма[править | править код]

Непрерывное пространство событий часто определяется как числитель условий A. Непрерывное пространство событий часто представляют как числитель. В дальнейшем полезно избавиться от знаменателя, используя формулу общей вероятности. Для 'fY(y), это становится интегралом:

Правило Байеса[править | править код]

Правило Байеса — это преобразованная теорема Байеса:

где

Это называется правилом Байеса или отношением правдоподобия. Разница в вероятности наступления двух событий — это просто отношение вероятностей этих двух событий. Таким образом,

- ,

- ,

Вывод формул[править | править код]

Для событий[править | править код]

Теорема Байеса может быть получена из определения вероятности:

Для случайных переменных[править | править код]

Для двух непрерывных случайных величин X и Y теорема Байеса может быть аналогично выведена из определения условного распределения:

См. также[править | править код]

Примечания[править | править код]

- ↑ Kahneman, et al, 2005, pp. 153—160.

- ↑ Bayes, Thomas, and Price, Richard (1763). «An Essay towards solving a Problem in the Doctrine of Chance. By the late Rev. Mr. Bayes, communicated by Mr. Price, in a letter to John Canton, M. A. and F. R. S.». Philosophical Transactions of the Royal Society of London 53: 370—418. Дата обращения: 21 апреля 2010. Архивировано из оригинала 17 марта 2019 года.

- ↑ Jeffreys, Harold (1973), Scientific Inference (3rd ed.), Cambridge University Press, p. 31, ISBN 978-0-521-18078-8

Литература[править | править код]

- Гмурман В. Е. Теория вероятностей и математическая статистика, — М.: Высшее образование. 2005

- Judgment under Uncertainty: Heuristics and Biases / Daniel Kahneman, et al. — 21st. — Cambridge University Press, 2005. — 555 p. — ISBN 978-0-521-28414-1.

- McGrayne, Sharon Bertsch. The Theory That Would Not Die: How Bayes' Rule Cracked the Enigma Code, Hunted Down Russian Submarines & Emerged Triumphant from Two Centuries of Controversy (англ.). — Yale University Press, 2011. — ISBN 978-0-300-18822-6.

- Andrew Gelman, John B. Carlin, Hal S. Stern, and Donald B. Rubin (2003), «Bayesian Data Analysis», Second Edition, CRC Press.

- Charles M. Grinstead and J. Laurie Snell (1997), «Introduction to Probability (2nd edition)», American Mathematical Society (free pdf available [1].

- Pierre-Simon Laplace. (1774/1986), «Memoir on the Probability of the Causes of Events», Statistical Science 1(3):364-378.

- Peter M. Lee (2012), «Bayesian Statistics: An Introduction», Wiley.

- Rosenthal, Jeffrey S. (2005): «Struck by Lightning: the Curious World of Probabilities». Harper Collings.

- Stephen M. Stigler (1986), «Laplace’s 1774 Memoir on Inverse Probability», Statistical Science 1(3):359-363.

- Stone, JV (2013). Chapter 1 of book «Bayes’ Rule: A Tutorial Introduction», University of Sheffield, England.

Ссылки[править | править код]

- Элиезер Юдковски. Наглядное объяснение теоремы Байеса

- The Theory That Would Not Die by Sharon Bertsch McGrayne New York Times Book Review by John Allen Paulos on 5 August 2011

- Weisstein, Eric W. Bayes' Theorem (англ.) на сайте Wolfram MathWorld.

- Bayes' theorem (англ.) на сайте PlanetMath.

- Bayes Theorem and the Folly of Prediction

- A tutorial on probability and Bayes’ theorem devised for Oxford University psychology students

- An Intuitive Explanation of Bayes' Theorem by Eliezer S. Yudkowsky

Для улучшения этой статьи желательно:

|

![{\displaystyle {\begin{aligned}P({\text{редкий}}\mid {\text{узор}})&={\frac {P({\text{узор}}\mid {\text{редкий}})\times P({\text{редкий}})}{P({\text{узор}}\mid {\text{редкий}})\times P({\text{редкий}})\,+\,P({\text{узор}}\mid {\text{обычный}})\times P({\text{обычный}})}}\\[8pt]&={\frac {0{,}98\times 0{,}001}{0{,}98\times 0{,}001+0{,}05\times 0{,}999}}\\[8pt]&\approx 0{,}019.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/99f473425064214488140f990a52c6a32b78e9a2)