Гауссовский процесс

В теории вероятностей и статистике гауссовский процесс — это стохастический процесс (или случайный процесс — это такое семейство случайных величин, статистические свойства элементов которого зависят от скалярного параметра t, которому придаётся смысл времени), такой что любой конечный набор этих случайных величин имеет многомерное нормальное распределение (гауссовское распределение), то есть любая конечная линейная комбинация из них нормально распределена. Распределение гауссовского процесса – это совместное распределение всех его случайных величин и, в силу чего, является распределением функций с непрерывной областью определения.

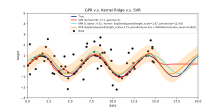

Если рассматривать гауссовский процесс как способ решения задач машинного обучения, то используется ленивое обучение и мера подобия между точками (функция ядра) для получения прогноза значения невидимой точки из обучающей выборки. В понятие прогноза, помимо самой оценки точки, входит информация о неопределенности — одномерное гауссовское распределение.[1]

Для вычисления прогнозов некоторых функций ядра используют метод матричной алгебры, кригинг.

Гауссовский процесс назван так в честь Карла Фридриха Гаусса, поскольку в его основе лежит понятие гауссовского распределения (нормального распределения). Гауссовский процесс может рассматриваться как бесконечномерное обобщение многомерных нормальных распределений. Эти процессы применяются в статистическом моделировании; в частности используются свойства нормальности. Например, если случайный процесс моделируется как гауссовский, то распределения различных производных величин, такие как среднее значение процесса в течение определенного промежутка времени и погрешность его оценки с использованием выборки значений, могут быть получены явно.

Определение[править | править код]

Случайный процесс с непрерывным временем является гауссовским тогда и только тогда, когда для любого конечного множества индексов из множества индексов

- многомерная гауссовская случайная величина.[2] То же самое, что и всякая линейная комбинация имеет одномерное нормальное (гауссовское) распределение. Используя характеристические функции случайных величин, свойство Гаусса можно сформулировать следующим образом: - гауссовское тогда и только тогда, когда для любого конечного множества индексов , существуют вещественные значения , где такие, что для всех выполнено равенство

Где - мнимая единица.

Числа и - ковариации и средние значения переменных в процессах соответственно[3].

Ковариационные функции[править | править код]

Главная особенность гауссовских процессов - они могут быть полностью определены второй порядковой статистикой[4]. Следовательно, ковариационная функция полностью определяет поведение процесса, если математическое ожидание гауссовского процесса равно нулю. Неотрицательная определенность функции делает возможным её спектральное разложение при помощи разложения Карунена — Лоэва. Через ковариационную функцию можно определить стационарность, изотропию, гладкость и периодичность процесса[4][5].

Стационарность выражает поведение процесса относительно расстояния между любыми двумя точками и . Если процесс стационарный, то он зависит от взаимного расположения своих точек, расстояния между ними, , в ином случае, он нестационарный, то есть зависит от фактического положения точек и . Примером может послужить частный случай процесса Орнштейна — Уленбека, процесс броуновского движения: он является стационарным.

Если процесс зависит только от , евклидова расстояния (не направления) между и , то процесс считается изотропным. Стационарный и изотропный процесс называют однородным;[6] на практике свойства стационарности и изотропии отражают различия(или, скорее, их отсутствие) в поведении процесса с учётом положения наблюдателя.

Суть гауссовских процессов заключается в получении априорных распределений вероятности, гладкость которых зависит от взятой ковариационной функции[4]. Если мы ожидаем, что для "лежащих близко" входных точек и соответствующие им выходные точки и также "лежат близко", тогда присутствует предположение о непрерывности функции. Если мы хотим допустить значительное смещение, то нужно выбрать более грубую ковариационную функцию. В качестве примеров крайнего поведения можно привести ковариационную функцию Орнштейна — Уленбека и квадратичную экспоненциальную функцию, где первая не дифференцируема нигде, а последняя бесконечно дифференцируема.

Под периодичностью понимается индуцирование периодических закономерностей в поведении процесса. Формально это достигается путём отображения входного значения на двумерный вектор

Обычные ковариационные функции[править | править код]

Существует ряд общих ковариационных функций:[5]

- Константа:

- Линейная функция:

- Гауссовский шум:

- Квадратичная экспоненциальная функция:

- Функция Орнштейна — Уленбека:

- Matérn:

- Периодическая функция:

- Рациональная квадратичная функция:

Здесь . Параметр является характеристикой масштаба длины процесса (практически, «насколько близко» две точки и должны быть, чтобы значительно влиять друг на друга), - это символ Кронекера и - среднеквадратическое отклонение колебаний шума. Кроме того, является модифицированной функцией Бесселя и - это гамма-функция, вычисленная по . Сложную ковариационную функцию можно определить как линейную комбинацию других более простых ковариационных функций затем, чтобы объединить различную информацию об имеющихся наборах данных.

Полученные результаты зависят от значений гиперпараметров (например, и ), определяющих поведение модели.

Броуновское движение как интеграл гауссовских процессов[править | править код]

Винеровский процесс (так называемое броуновское движение) является интегралом гауссовского процесса белого шума. Он не стационарен, однако имеет стационарные приращения.

Процесс Орнштейна — Уленбека — это стационарный гауссовский процесс.

Броуновский мост (подобный процессу Орнштейна — Уленбека) является примером гауссовского процесса, приращения которого не являются независимыми.

Дробное броуновское движение является гауссовским процессом, ковариационная функция которого является обобщением функции винеровского процесса.

Приложения[править | править код]

Гауссовский процесс может быть использован как априорное распределение вероятностей функций в байесовском выводе.[5][8] Для любого множества из N точек в нужной области функций возьмите многомерное гауссовское распределение, ковариационный матричный параметр которого является определителем Грама взятых N точек с некоторым желаемым ядром, и выборку из этого распределения.

Вывод непрерывных значений на основе гауссовского процесса, определяемого предыдущими ковариациями, известен как кригинг (регрессия на основе гауссовского процесса). Поэтому, гауссовские процессы полезны в качестве мощного нелинейного многомерного инструмента интерполяции. Регрессия на основе гауссовского процесса может быть дополнительно расширена для решения задач обучения как с учителем, так и без (самообучение).

Прогноз гауссовского процесса или кригинг[править | править код]

Когда речь идёт об основной проблеме регрессии на основе гауссовского процесса (кригинге), предполагается, что для гауссовского процесса , наблюдаемого в координатах , вектор значений является всего лишь одной из выборок многомерного гауссовского распределения, размерность которого равна числу наблюдаемых координат . Следовательно, согласно допущению о нулевом распределении, , где - ковариационная матрица между всеми возможными парами для заданного множества гиперпараметров .[5] Таким образом, логарифм предельной вероятности равен:

и максимизация этой предельной вероятности по отношению к даёт полную характеристику гауссовского процесса . Первое выражение зависит от неспособности модели соответствовать наблюдаемым значениям, а второе выражение прямо пропорционально сложности модели. Указав и сделав прогноз о ненаблюдаемых значениях в координатах , останется сделать график выборок из прогностического распределения , где последующая средняя оценка определяется как

и последующая оценка дисперсии B определяется как

где - ковариация между новой оценкой координаты и всеми другими наблюдаемыми координатами для данного гиперпараметрического вектора , и определены как и прежде, а является дисперсией в точке , продиктованной вектором . Последующая средняя оценка ("точечная оценка") является линейной комбинацией наблюдений ; аналогичным образом дисперсия фактически не зависит от наблюдений . Известным узким местом в прогнозировании гауссовского процесса является то, что вычислительная сложность прогнозирования является кубической по числу точек , то есть вычисление может быть невозможным для больших наборов данных.[4] Чтобы обойти эту проблему, ведутся работы по разреженным гауссовским процессам, которые обычно основаны на идее построения репрезентативного набора для данного процесса .[9][10]

См. также[править | править код]

Примечания[править | править код]

- ↑ Platypus Innovation: A Simple Intro to Gaussian Processes (a great data modelling tool). Дата обращения: 15 января 2018. Архивировано 1 мая 2018 года.

- ↑ MacKay, David, J.C.[англ.]. Information Theory, Inference, and Learning Algorithms (англ.). — Cambridge University Press, 2003. — P. 540. — ISBN 9780521642989. Архивировано 19 октября 2016 года.. — «"The probability distribution of a function is a Gaussian processes if for any finite selection of points , the density is a Gaussian"».

- ↑ Dudley, R.M. Real Analysis and Probability. — Wadsworth and Brooks/Cole, 1989.

- ↑ 1 2 3 4 Barber, David. Bayesian Reasoning and Machine Learning. — Cambridge University Press, 2012. — ISBN 978-0-521-51814-7. Архивировано 11 ноября 2020 года.

- ↑ 1 2 3 4 Rasmussen, C.E.; Williams, C.K.I. Gaussian Processes for Machine Learning. — MIT Press, 2006. — ISBN 0-262-18253-X. Архивировано 22 мая 2021 года.

- ↑ Grimmett, Geoffrey; David Stirzaker. Probability and Random Processes (англ.). — Oxford University Press, 2001. — ISBN 0198572220.

- ↑ The documentation for scikit-learn also has similar examples Архивная копия от 19 апреля 2021 на Wayback Machine.

- ↑ Архивированная копия (англ.). Дата обращения: 15 января 2018. Архивировано из оригинала 4 марта 2016 года.Архивированная копия. Дата обращения: 15 января 2018. Архивировано из оригинала 4 марта 2016 года.

- ↑ Smola, A.J.; Schoellkopf, B. Sparse greedy matrix approximation for machine learning (англ.) // Proceedings of the Seventeenth International Conference on Machine Learning : journal. — 2000. — P. 911—918.

- ↑ Csato, L.; Opper, M. Sparse on-line Gaussian processes (англ.) // Neural Computation[англ.]. — 2002. — Vol. 14. — P. 641—668. — doi:10.1162/089976602317250933.

Внешние ссылки[править | править код]

- The Gaussian Processes Web Site, including the text of Rasmussen and Williams' Gaussian Processes for Machine Learning

- A gentle introduction to Gaussian processes

- A Review of Gaussian Random Fields and Correlation Functions

Программное обеспечение[править | править код]

- STK: a Small (Matlab/Octave) Toolbox for Kriging and GP modeling

- Kriging module in UQLab framework (Matlab)

- Matlab/Octave function for stationary Gaussian fields

- Yelp MOE – A black box optimization engine using Gaussian process learning

- ooDACE – A flexible object-oriented Kriging matlab toolbox.

- GPstuff – Gaussian process toolbox for Matlab and Octave

- GPy – A Gaussian processes framework in Python

- Interactive Gaussian process regression demo

- Basic Gaussian process library written in C++11

- scikit-learn – A machine learning library for Python which includes Gaussian process regression and classification

- [1] - The Kriging toolKit (KriKit) is developed at the Institute of Bio- and Geosciences 1 (IBG-1) of Forschungszentrum Jülich (FZJ)