Нормальное распределение

| Нормальное распределение | |

|---|---|

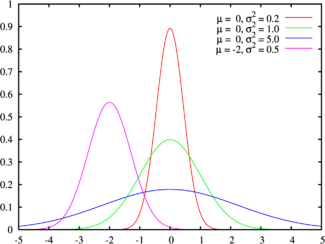

Зеленая линия соответствует стандартному нормальному распределениюПлотность вероятности | |

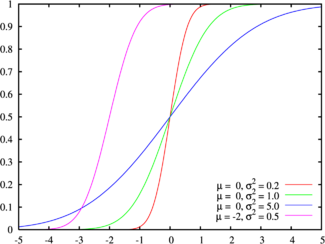

Цвета на этом графике соответствуют графику наверхуФункция распределения | |

| Обозначение | |

| Параметры |

μ — коэффициент сдвига (вещественный) σ > 0 — коэффициент масштаба (вещественный, строго положительный) |

| Носитель | |

| Плотность вероятности | |

| Функция распределения | |

| Математическое ожидание | |

| Медиана | |

| Мода | |

| Дисперсия | |

| Коэффициент асимметрии | |

| Коэффициент эксцесса | |

| Дифференциальная энтропия | |

| Производящая функция моментов | |

| Характеристическая функция | |

Норма́льное распределе́ние[1][2], также называемое распределением Гаусса или Гаусса — Лапласа[3], или колоколообразная кривая — непрерывное распределение вероятностей с пиком в центре и симметричными боковыми сторонами, которое в одномерном случае задаётся функцией плотности вероятности, совпадающей с функцией Гаусса:

- ,

- где параметр — математическое ожидание (среднее значение), медиана и мода распределения, а параметр — среднеквадратическое отклонение, — дисперсия распределения.

Таким образом, одномерное нормальное распределение является двухпараметрическим семейством распределений, которое принадлежит экспоненциальному классу распределений[4]. Многомерный случай описан в статье «Многомерное нормальное распределение».

Стандартным нормальным распределением называется нормальное распределение с математическим ожиданием и стандартным отклонением

Общие сведения[править | править код]

Если величина является суммой многих случайных слабо взаимозависимых величин, каждая из которых вносит малый вклад относительно общей суммы, то центрированное и нормированное распределение такой величины при достаточно большом числе слагаемых стремится к нормальному распределению.

Это следует из центральной предельной теоремы теории вероятностей. В окружающем нас мире часто встречаются величины, значение которых определяется совокупностью многих независимых факторов. Этот факт, а также то, что распределение считалось типичным, обычным, привели к тому, что в конце XIX века стал использоваться термин «нормальное распределение». Нормальное распределение играет заметную роль во многих областях науки, например в математической статистике и статистической физике.

Случайная величина, имеющая нормальное распределение, называется нормальной, или гауссовской, случайной величиной.

Определения[править | править код]

Стандартное нормальное распределение[править | править код]

Наиболее простой случай нормального распределения — стандартное нормальное распределение — частный случай, когда и Его плотность вероятности равна:

Множитель в выражении обеспечивает условие нормировки интеграла [5]. Поскольку множитель в экспоненте обеспечивает дисперсию равную единице, то и стандартное отклонение равно 1. Функция симметрична в точке её значение в ней максимально и равно Точки перегиба функции: и

Гаусс называл стандартным нормальным распределение с то есть:

Нормальное распределение с параметрами μ, σ[править | править код]

Каждое нормальное распределение — это вариант стандартного нормального распределения, область значений которого растягивается множителем (стандартное отклонение) и переносится на (математическое ожидание):

являются параметрами нормального распределения. Плотность вероятности должна нормироваться так что интеграл равен 1.

Если — стандартная нормальная случайная величина, то величина будет иметь нормальное распределение с математическим ожиданием и стандартным отклонением Наоборот, если — нормальная величина с параметрами и то будет иметь стандартное нормальное распределение.

Если в экспоненте плотности вероятности раскрыть скобки и учитывать, что , то:

Таким образом, плотность вероятности каждого нормального распределения представляет собой экспоненту квадратичной функции:

- где

Отсюда можно выразить среднее значение как а дисперсию как Для стандартного нормального распределения и

Обозначение[править | править код]

Плотность вероятности стандартного нормального распределения (с нулевым средним и единичной дисперсией) часто обозначается греческой буквой (фи)[6]. Также достаточно часто используется альтернативное начертание греческой буквы фи .

Нормальное распределение часто обозначается или [7]. Если случайная величина распределена по нормальному закону со средним и вариацией то пишут:

Функция распределения[править | править код]

Функция распределения стандартного нормального распределения (нормальное интегральное распределение) обычно обозначается заглавной греческой буквой (фи), в России называется функцией Лапласа и представляет собой интеграл:

С ней связана функция ошибок (интеграл вероятности) дающий вероятность того, что нормальная случайная величина со средним 0 и вариацией 1/2 попадёт в отрезок :

Эти интегралы не выражаются в элементарных функциях и называются специальными функциями. Многие их численные приближения известны. См. ниже.

Функции связаны, в частности, соотношением:

- .

Нормальное распределение с плотностью средним и отклонением имеет следующую функцию распределения:

Можно использовать функцию — она даст вероятность того, что значение стандартной нормальной случайной величины превысит :

- .

График стандартной нормальной функции распределения имеет 2-кратную вращательную симметрию относительно точки (0;1/2), то есть Её неопределенный интеграл равен:

Функция распределения стандартной нормальной случайной величины может быть разложена с помощью метода интегрирования по частям в ряд:

где знак означает двойной факториал.

Асимптотическое разложение функции распределения для больших может быть также произведено интегрированием по частям.

Стандартное отклонение[править | править код]

Для нормального распределения количество значений, отличающихся от среднего на число, меньшее чем одно стандартное отклонение, составляют 68,27 % выборок. В то же время количество значений, отличающиеся от среднего на два стандартных отклонения, составляют 95,45 %, а на три стандартных отклонения — 99,73 %.

Около 68 % значений из нормального распределения находятся на расстоянии не более одного стандартного отклонения σ от среднего; около 95 % значений лежат расстоянии не более двух стандартных отклонений; и 99,7 % не более трёх. Этот факт является частным случаем правила 3 сигм для нормальной выборки.

Более точно, вероятность получить нормальное число в интервале между и равна:

С точностью до 12 значащих цифр значения для приведены в таблице[8]:

| OEIS | |||||

|---|---|---|---|---|---|

| 1 | 0,682689492137 | 0,317310507863 |

|

A178647 | |

| 2 | 0,954499736104 | 0,045500263896 |

|

A110894 | |

| 3 | 0,997300203937 | 0,002699796063 |

|

A270712 | |

| 4 | 0,999936657516 | 0,000063342484 |

| ||

| 5 | 0,999999426697 | 0,000000573303 |

| ||

| 6 | 0,999999998027 | 0,000000001973 |

|

Свойства[править | править код]

Моменты[править | править код]

Моментами и абсолютными моментами случайной величины называются математические ожидания случайных величин и соответственно. Если математическое ожидание случайной величины то эти параметры называются центральными моментами. В большинстве случаев представляют интерес моменты для целых

Если имеет нормальное распределение, то для неё существуют (конечные) моменты при всех с действительной частью больше −1. Для неотрицательных целых центральные моменты таковы:

Здесь — натуральное число, а запись означает двойной факториал числа то есть (поскольку в данном случае нечётно) произведение всех нечётных чисел от 1 до

Центральные абсолютные моменты для неотрицательных целых таковы:

Последняя формула справедлива также для произвольных .

Преобразование Фурье и характеристическая функция[править | править код]

Преобразование Фурье нормальной плотности вероятности с математическим ожиданием стандартным отклонением равно[9]:

- где есть мнимая единица.

Если математическое ожидание то первый множитель равен 1, и преобразование Фурье, с точностью до константы есть нормальная плотность вероятности на частотных интервалах, с математическим ожиданием равным 0 и стандартным отклонением В частности, стандартное нормальное распределение есть собственная функция от преобразования Фурье.

В теории вероятности, преобразование Фурье плотности распределения действительной случайной величины близко связано с характеристической функцией этой величины, которая определена как математическое ожидание от и является функцией вещественной переменной (частотный параметр преобразования Фурье). Определение может быть распространено и на комплексную переменную [10]. Соотношение записывается так:

Бесконечная делимость[править | править код]

Нормальное распределение является бесконечно делимым.

Если случайные величины и независимы и имеют нормальное распределение с математическими ожиданиями и и дисперсиями и соответственно, то также имеет нормальное распределение с математическим ожиданием и дисперсией

Отсюда вытекает, что нормальная случайная величина представима как сумма произвольного числа независимых нормальных случайных величин.

Максимальная энтропия[править | править код]

Нормальное распределение имеет максимальную дифференциальную энтропию среди всех непрерывных распределений, дисперсия которых не превышает заданную величину[11][12].

Правило трёх сигм для гауссовской случайной величины[править | править код]

Правило трёх сигм () — практически все значения нормально распределённой случайной величины лежат в интервале:

- где — математическое ожидание и параметр нормальной случайной величины.

Более точно — приблизительно с вероятностью 0,9973 значение нормально распределённой случайной величины лежит в указанном интервале.

Моделирование нормальных псевдослучайных величин[править | править код]

При компьютерном моделировании, особенно при применении метода Монте-Карло, желательно использовать величины, распределенные по нормальному закону. Многие алгоритмы дают стандартные нормальные величины, так как нормальную величину можно получить как:

- где Z — стандартная нормальная величина.

Алгоритмы также используют различные преобразования равномерных величин. Простейшие приближённые методы моделирования основываются на центральной предельной теореме. Если сложить достаточно большое количество независимых одинаково распределённых величин с конечной дисперсией, то сумма будет иметь распределение, близкое к нормальному. Например, если сложить 100 независимых стандартно равномерно распределённых случайных величин, то распределение суммы будет приближённо нормальным.

Для программного генерирования нормально распределённых псевдослучайных величин предпочтительнее использовать преобразование Бокса — Мюллера. Оно позволяет генерировать одну нормально распределённую величину на базе одной равномерно распределённой.

Также существует алгоритм Зиккурат, который работает даже быстрее преобразования Бокса — Мюллера. Тем не менее, сложнее в реализации, но его применение оправдано в случаях, когда требуется генерирование очень большого числа неравномерно распределённых случайных чисел.

Нормальное распределение в природе и приложениях[править | править код]

Нормальное распределение часто встречается в природе. Например, следующие случайные величины хорошо моделируются нормальным распределением:

- отклонение при стрельбе;

- погрешности измерений (однако погрешности некоторых измерительных приборов имеют иное распределение);

- некоторые характеристики живых организмов в популяции.

Такое широкое распространение этого распределения связано с тем, что оно является бесконечно делимым непрерывным распределением с конечной дисперсией. Поэтому к нему в пределе приближаются некоторые другие, например биномиальное и пуассоновское. Этим распределением моделируются многие недетерминированные физические процессы[13].

Многомерное нормальное распределение используется при исследовании многомерных случайных величин (случайных векторов). Одним из многочисленных примеров таких приложений является исследование параметров личности человека в психологии и психиатрии.

Связь с другими распределениями[править | править код]

- Нормальное распределение является распределением Пирсона типа XI[14].

- Отношение пары независимых стандартных нормально распределенных случайных величин имеет распределение Коши[15]. То есть, если случайная величина представляет собой отношение (где и — независимые стандартные нормальные случайные величины), то она будет обладать распределением Коши.

- Если — совместно независимые стандартные нормальные случайные величины, то есть то случайная величина имеет распределение хи-квадрат с k степенями свободы.

- Если случайная величина подчинена логнормальному распределению, то её натуральный логарифм имеет нормальное распределение. То есть, если то И наоборот, если то

- Если независимые нормально распределенные случайные величины с математическими ожиданиями и дисперсиями то их выборочное среднее независимо от выборочного стандартного отклонения[16], а отношение следующих двух величин будет иметь t-распределение с степенями свободы:

- Если независимые стандартные нормальные случайные величины, то отношение нормированных сумм квадратов будет иметь распределение Фишера с ( ) степенями свободы[17]:

- Отношение квадратов двух стандартных нормальных случайных величин имеет распределение Фишера со степенями свободы

История[править | править код]

Впервые нормальное распределение как предел биномиального распределения при появилось в 1738 году во втором издании работы Муавра «Доктрина случайностей»[англ.][18]. Это было первое доказательство частного случая центральной предельной теоремы. В 1809 году Гаусс в сочинении «Теория движения небесных тел» ввёл это распределение как возникающее в результате многократных измерений движения небесных тел. Однако Гаусс вывел формулу для действительных случайных величин из принципа достижения максимума совместной плотности всех измерений в точке с координатами, равными среднему всех измерений. Этот принцип впоследствии подвергался критике. В 1812 году Лаплас в теореме Муавра — Лапласа обобщил результат Муавра для произвольного биномиального распределения, то есть для сумм одинаково распределённых независимых бинарных величин[3].

См. также[править | править код]

- Аддитивный белый гауссовский шум

- Логнормальное распределение

- Равномерное распределение

- Центральная предельная теорема

- Двумерное нормальное распределение

- Многомерное нормальное распределение

- Распределение хи-квадрат

- Статистический критерий

- Частотное распределение

Примечания[править | править код]

- ↑ Вентцель Е. С. Теория вероятностей. — 10-е изд., стереотипное.. — М.: Academia, 2005. — 576 с. — ISBN 5-7695-2311-5.

- ↑ Ширяев А. Н. Вероятность. — М.: Наука, 1980.

- ↑ 1 2 Математический энциклопедический словарь. — М.: Советская энциклопедия, 1988. — С. 139—140.

- ↑ Wasserman L. All of Statistics. — New York, NY: Springer, 2004. — С. 142. — 433 с. — ISBN 978-1-4419-2322-6.

- ↑ Доказательство см. Гауссов интеграл

- ↑ Halperin, Hartley & Hoel, 1965, item 7.

- ↑ McPherson (1990)

- ↑ Wolfram|Alpha: Computational Knowledge Engine. Wolframalpha.com. Дата обращения: 3 марта 2017.

- ↑ Bryc (1995, p. 23)

- ↑ Bryc (1995, p. 24)

- ↑ Cover, Thomas M.; Thomas, Joy A. Elements of Information Theory. — John Wiley and Sons, 2006. — С. 254.

- ↑ Park, Sung Y.; Bera, Anil K. Maximum Entropy Autoregressive Conditional Heteroskedasticity Model (англ.) // Journal of Econometrics[англ.] : journal. — Elsevier, 2009. — P. 219—230. Архивировано 7 марта 2016 года.

- ↑ Талеб Н. Н. Чёрный лебедь. Под знаком непредсказуемости = The Black Swan: The Impact of the Highly Improbable. — КоЛибри, 2012. — 525 с. — ISBN 978-5-389-00573-0.

- ↑ Королюк, 1985, с. 135.

- ↑ Галкин В. М., Ерофеева Л. Н., Лещева С. В. Оценки параметра распределения Коши : [арх. 30 июля 2017] // Труды Нижегородского государственного технического университета им. Р. Е. Алексеева. — 2014. — № 2(104). — С. 314—319. — УДК 513.015.2(G).

- ↑ Lukacs, Eugene. A Characterization of the Normal Distribution (англ.) // The Annals of Mathematical Statistics[англ.] : journal. — 1942. — Vol. 13, no. 1. — P. 91—3. — ISSN 0003-4851. — doi:10.1214/aoms/1177731647. — .

- ↑ Lehmann, E. L.[англ.]. Testing Statistical Hypotheses. — 2nd. — Springer[англ.], 1997. — С. 199. — ISBN 978-0-387-94919-2.

- ↑ The doctrine of chances; or, a method of calculating the probability of events in play, L., 1718, 1738, 1756; L., 1967 (репродуцир. изд.); Miscellanea analytica de scriebus et quadraturis, L., 1730.

Литература[править | править код]

- Королюк В. С., Портенко Н. И., Скороход А. В., Турбин А. Ф. Справочник по теории вероятностей и математической статистике. — М.: Наука, 1985. — 640 с.

- Halperin, Max; Hartley, Herman O.; Hoel, Paul G. Recommended Standards for Statistical Symbols and Notation. COPSS Committee on Symbols and Notation (англ.) // The American Statistician[англ.] : journal. — 1965. — Vol. 19, no. 3. — P. 12—14. — doi:10.2307/2681417. — .

- McPherson, Glen. Statistics in Scientific Investigation: Its Basis, Application and Interpretation (англ.). — Springer-Verlag, 1990. — ISBN 978-0-387-97137-7.

- Bryc, Wlodzimierz. The Normal Distribution: Characterizations with Applications (англ.). — Springer-Verlag, 1995. — ISBN 978-0-387-97990-8.

Ссылки[править | править код]

- Таблица значений функции стандартного нормального распределения

- Онлайн расчёт вероятности нормального распределения

В другом языковом разделе есть более полная статья Normal distribution (англ.). |

Для улучшения этой статьи желательно:

|

![{\displaystyle \Phi ({\frac {x-\mu }{\sigma }})={\frac {1}{2}}\left[1+\operatorname {erf} \left({\frac {x-\mu }{\sqrt {2\sigma ^{2}}}}\right)\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2e6761619c13b85e117f8cf8aa6dbc7b4ec9554e)

![{\displaystyle [-x,x]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e23c41ff0bd6f01a0e27054c2b85819fcd08b762)

![{\displaystyle \Phi (x)={\frac {1}{2}}\left[1+\operatorname {erf} \left({\frac {x}{\sqrt {2}}}\right)\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c7831a9a5f630df7170fa805c186f4c53219ca36)

![{\displaystyle F(x)=\Phi \left({\frac {x-\mu }{\sigma }}\right)={\frac {1}{2}}\left[1+\operatorname {erf} \left({\frac {x-\mu }{\sigma {\sqrt {2}}}}\right)\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6a75caa2df3861960f6c6a5ac91f0b0fa6d79504)

![{\displaystyle \Phi (x)={\frac {1}{2}}+{\frac {1}{\sqrt {2\pi }}}\cdot e^{-x^{2}/2}\left[x+{\frac {x^{3}}{3}}+{\frac {x^{5}}{3\cdot 5}}+\cdots +{\frac {x^{2n+1}}{(2n+1)!!}}+\cdots \right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b755fcac449fe404b290943b01b01eab9c50440a)

![{\displaystyle \mathbb {E} \left[X^{p}\right]={\begin{cases}0&p=2n+1,\\\sigma ^{p}\,\left(p-1\right)!!&p=2n.\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c39f9a1d5eadfbc872b3cd41f8135576e3123bc4)

![{\displaystyle \mathbb {E} \left[\left|X\right|^{p}\right]=\sigma ^{p}\,\left(p-1\right)!!\cdot \left.{\begin{cases}{\sqrt {\frac {2}{\pi }}}&p=2n+1,\\1&p=2n.\end{cases}}\right\}=\sigma ^{p}\cdot {\frac {2^{\frac {p}{2}}\Gamma \left({\frac {p+1}{2}}\right)}{\sqrt {\pi }}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c45215d47f1e0fc958abfae9a8d7137995cf90a8)

![{\displaystyle t={\frac {{\overline {X}}-\mu }{S/{\sqrt {n}}}}={\frac {{\frac {1}{n}}(X_{1}+\cdots +X_{n})-\mu }{\sqrt {{\frac {1}{n(n-1)}}\left[(X_{1}-{\overline {X}})^{2}+\cdots +(X_{n}-{\overline {X}})^{2}\right]}}}\sim t_{n-1}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/36ff0d3c79a0504e8f259ef99192b825357914d7)